Usages des IA en CRM : principes de mise en oeuvre et retours d’expérience par Equancy

J’ai été récemment invité à une présentation d’Equancy et Dataventure sur le thème ‘Future of Augmented CRM – IA & Relation Client. ‘ De nombreux concepts et cas clients sur le CRM boosté par l’IA ont été présentés à cette occasion .

Je vous propose de réaliser un focus sur quelques concepts et cas particulièrement intéressants :

- Matrice d’analyse de l’IA sur le CRM avec les grandes lignes de l’impact de l’IA dans le CRM par typologie d’outils

- PICARD qui personnalise finement ses campagnes à partir de la météo

- LA REDOUTE avec l’usage de la météo pour affiner les campagnes adressées

- L’IA Agentique a le potentiel de changer le CRM en gestion de campagne BtoC

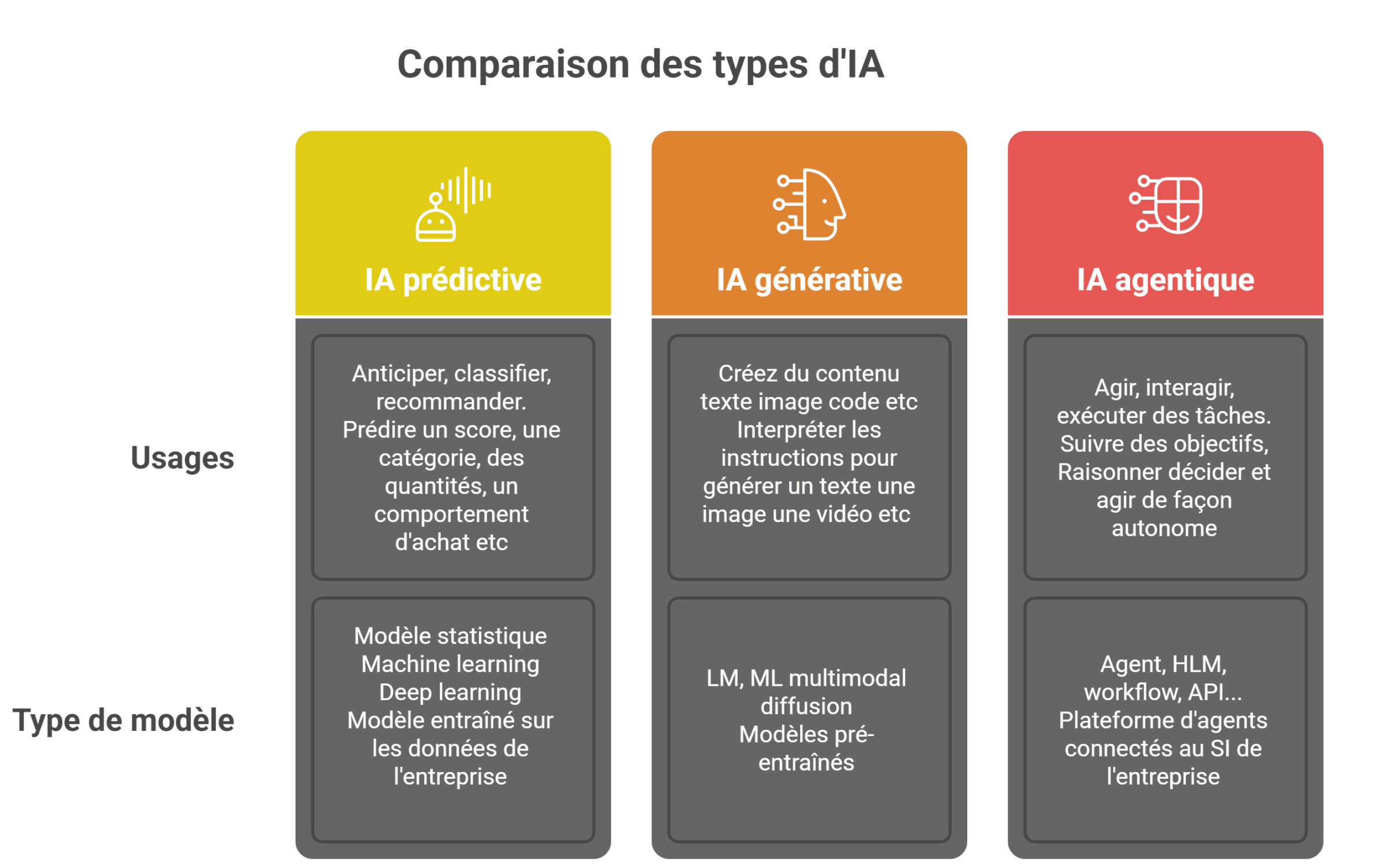

1 Matrice d’analyse des types d’IA sur le CRM.

En début de présentation, Equancy a dévoilé une matrice intéressante croisant les types d’IA (prédictive,générative et agentique) avec les cas d’usage et les types de modèle.

A noter que la catégorie ‘prédictive’ n’a pas attendu l’IA générative pour s’implanter dans les entreprises où elle est largement utilisée.

L’IA générative est en train de se déployer largement en entreprise en focalisant surtout sur le travail d’analyse et de la structuration des données/contenus.

L’Agentique est perçu comme pouvant révolutionner le métier du CRM, sa fonction clé étant de réaliser des actions opérationnelles.

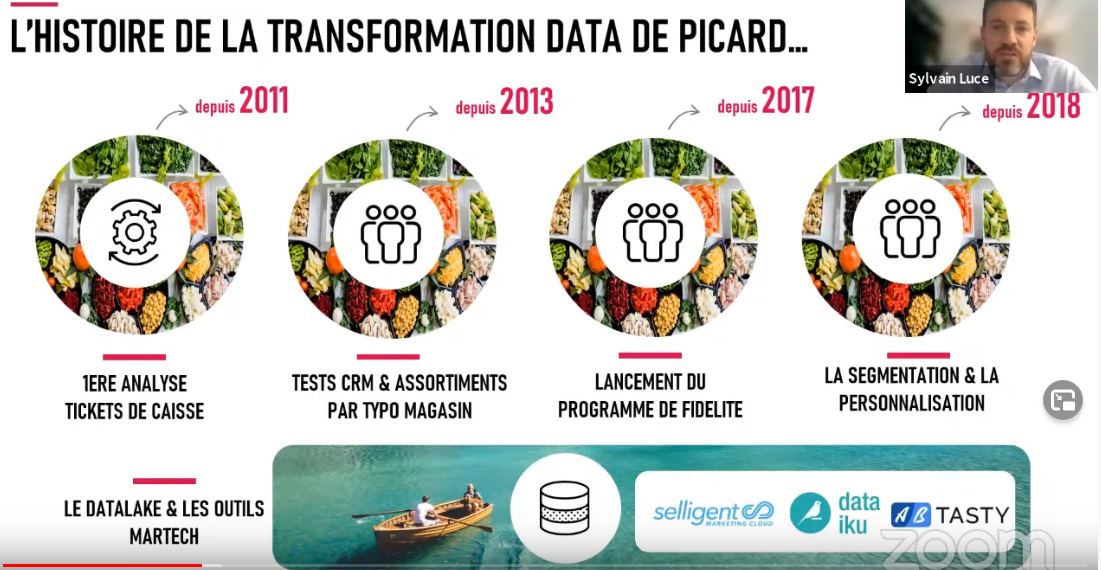

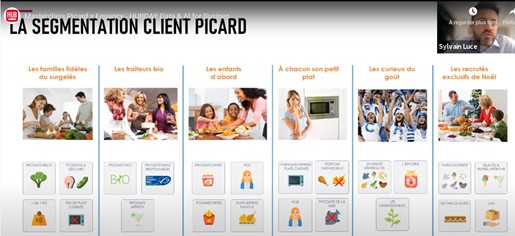

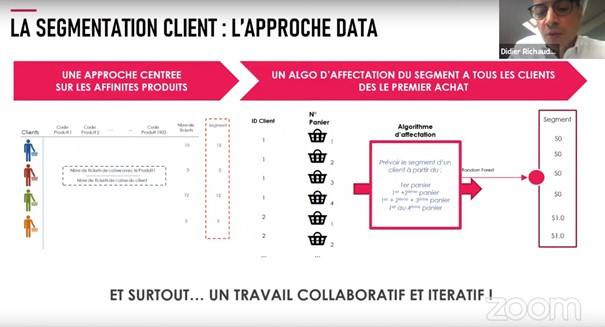

2 Picard avec une approche CRM ‘météotisée’.

L’impact de la météo sur la vente de certains produits est bien connu. Au première chaleur les ventilateurs se vendent comme des petits pains, aux premières pluie et froid, les vêtements d’hiver subissent des hausses importantes.

Chez Picard, l’impact de la météo est un facteur important pour la vente notamment de glace et de plats chauds (congelés bien sûr).

Proposez des glaces en promotion lorsqu’il pleut n’a pas le même impact que proposer des glaces quand les températures dépassent les 30° (d’ailleurs, a-t-on besoin d’une promotion dans ce dernier contexte ?).

La météo est une donnée très variable sur le territoire français, peu homogène donc la granularité est à définir finement (région, département, ville … ).

D’autre part, il est intéressant de moduler les promotions en fonction des conditions météorologiques.

Dans ce contexte complexe Equancy a travaillé sur un projet d’IA prédictive visant à booster leurs ventes avec les prévisions météo.

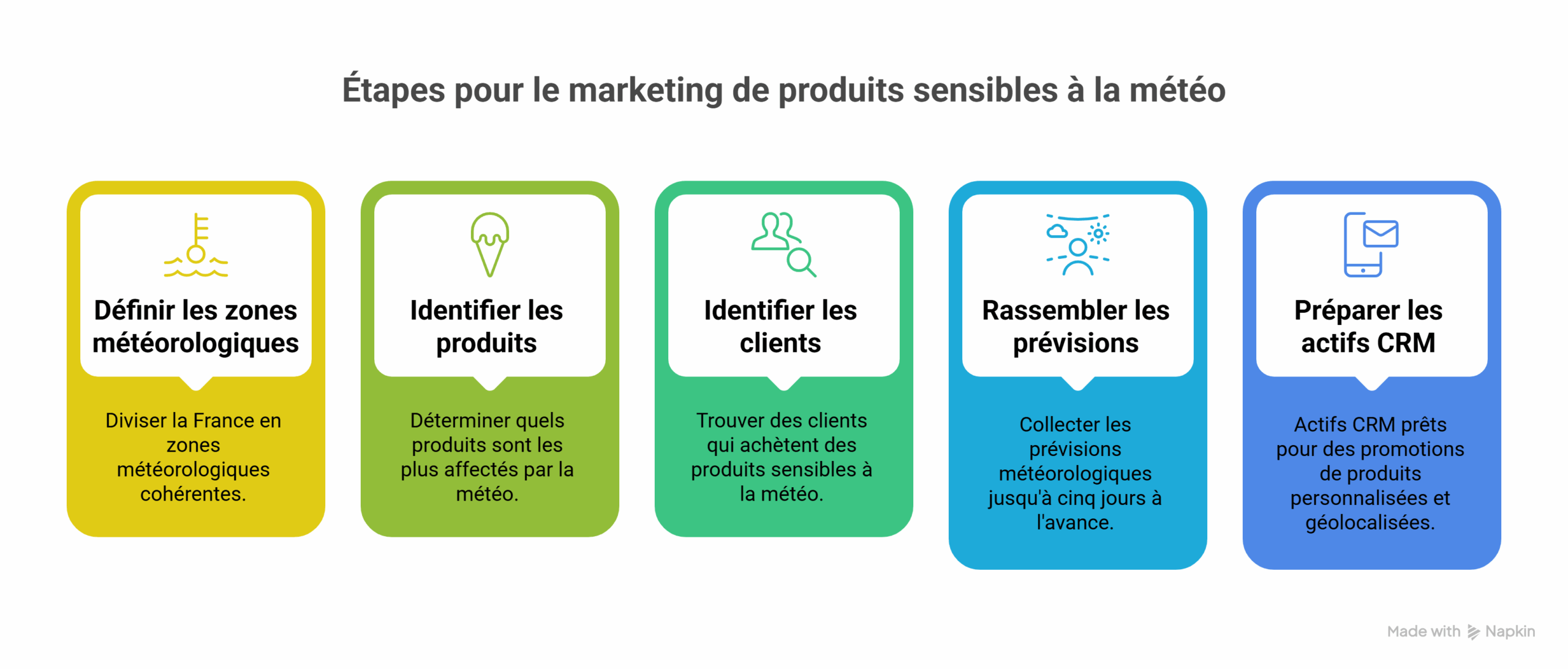

Les étapes du projet ont été les suivantes :

- La granularité d’un type de météo homogène ne respecte pas les régions. Il faut donc travailler sur d’autres dimensions : départements voir plus finement si les données sont disponibles et la granularité n’est pas trop complexe à gérer,

- La météo doit être qualifiée sur plusieurs dimensions (température, degré de couverture nuageuse, humidité …) car même si la température est importante la couverture nuageuse l’est aussi,

- La fréquence de mise à jour doit être correctement calculée suivant les applications,

- Pour résoudre ce problème, des zones météo ont été découpées sur la France après analyse statistique pour avoir des zones de promotion homogène en fonction du temps et des produits (20 zones météo cohérentes ont été définies)

- Un outil maison dédié à la prévision météo.

Picard, avec l’aide d’Equancy a donc développé un outil qui croise les données météorologiques avec les performances de vente. Cet outil identifie les corrélations entre les conditions climatiques et les ventes de produits spécifiques, permettant d’anticiper les comportements d’achat et d’ajuster les stocks et les campagnes email et push notification en conséquence.

Sur une application spécifique, les équipes CRM peuvent schématiquement :

-

choisir un produit et une zone géographique,

-

visualiser l’impact météo sur les ventes passées,

-

simuler l’effet d’un scénario de pluie ou de chaleur avec des scores d’impact sur la carte,

- …

- La campagne nécessite d’être optimisée avec des tests A/B réguliers:

Chaque campagne est construite en amont, avec plusieurs variantes scénarisées. Une même création d’email peut ainsi comporter trois accroches différentes, sélectionnées dynamiquement selon les prévisions. Dans l’application mobile, les pushs varient selon la géolocalisation météo.

« on écrit plusieurs histoires possibles … puis la météo choisit pour nous celle qui sera racontée » souligne Picard

Cette démarche a nécessité des tests A/B réguliers.

Ceux-ci ont démontré l’efficacité de cette approche, avec des augmentations significatives des taux de conversion et une meilleure satisfaction client. L’analyse continue des données permet d’affiner les modèles prédictifs et d’améliorer la précision des campagnes pour de nombreux produits.

On voit bien la complexité de mise en œuvre à partir d’une idée simple et de bon sens : « adapter ces produits à la météo locale »

Le résultat nécessite beaucoup de précautions et finalement un apprentissage au travers de tests réguliers pour être bien sûr du bon l’impact de la tactique promotionnelle par région et produit.

3 La redoute guette aussi la météo

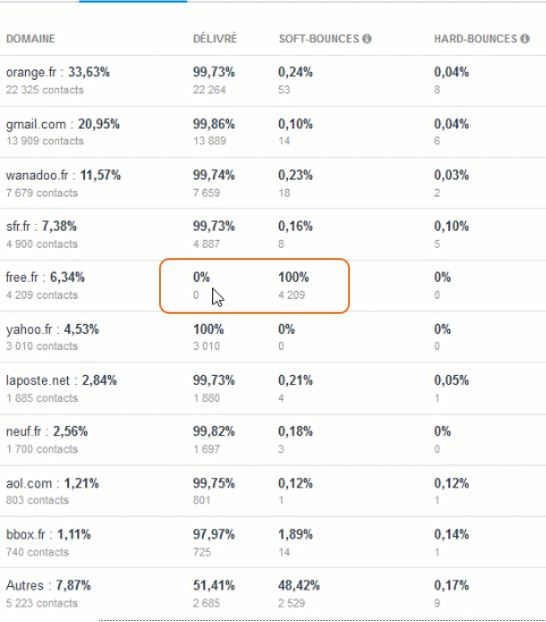

La Redoute a adopté une logique CRM similaire à celle de Picard, en utilisant les données météorologiques pour ajuster ses actions promotionnelles selon les régions principalement sur mobile.

- Un taux de remise modulé en fonction de la météo.

Une des pratiques intéressantes de La Redoute, c’est la modulation du taux de remise. Lorsqu’il pleut dans une zone, les promotions sont plus agressives pour déclencher l’achat (ex. -30 % sur les glaces). Mais s’il fait chaud, les remises baissent : la demande étant naturelle, la marge est préservée.

Ce passage d’une logique statique à une logique dynamique s’appuie sur des seuils déclencheurs automatisés, fondés sur la température, l’ensoleillement ou encore le taux d’humidité

- L’un des cas les plus emblématiques évoqués concerne la vente de maillots de bain.L’été quand il fait « beau » (concrètement du soleil) , les ventes de maillots de bain augmentent de 35 % versus les jours d’été où il ne fait pas « beau » (couverture nuageuse forte).

Aussi la pratique est la suivante : - À date identique, l’enseigne applique une remise de -30 % dans les zones sur lesquelles le ciel est couvert, et seulement -5 % là où le soleil brille. Marge bien meilleure que sur une promotion homogène à -30%

Ce système repose sur l’identification automatique de la localisation via l’adresse IP de connexion, couplée à un moteur de personnalisation du site web. Il s’agit donc d’un pilotage fin des promotions, en temps réel, qui mobilise des scénarios prédéfinis d’AB tests, avant généralisation.

Le canal utilisé est le Web (en personnalisation) et probablement le push notification et l’email.

Une approche agile qui permet à La Redoute d’éviter la logique de « soldes uniformes », trop coûteuse, et de s’inscrire dans une stratégie de valeur plus que de volume.

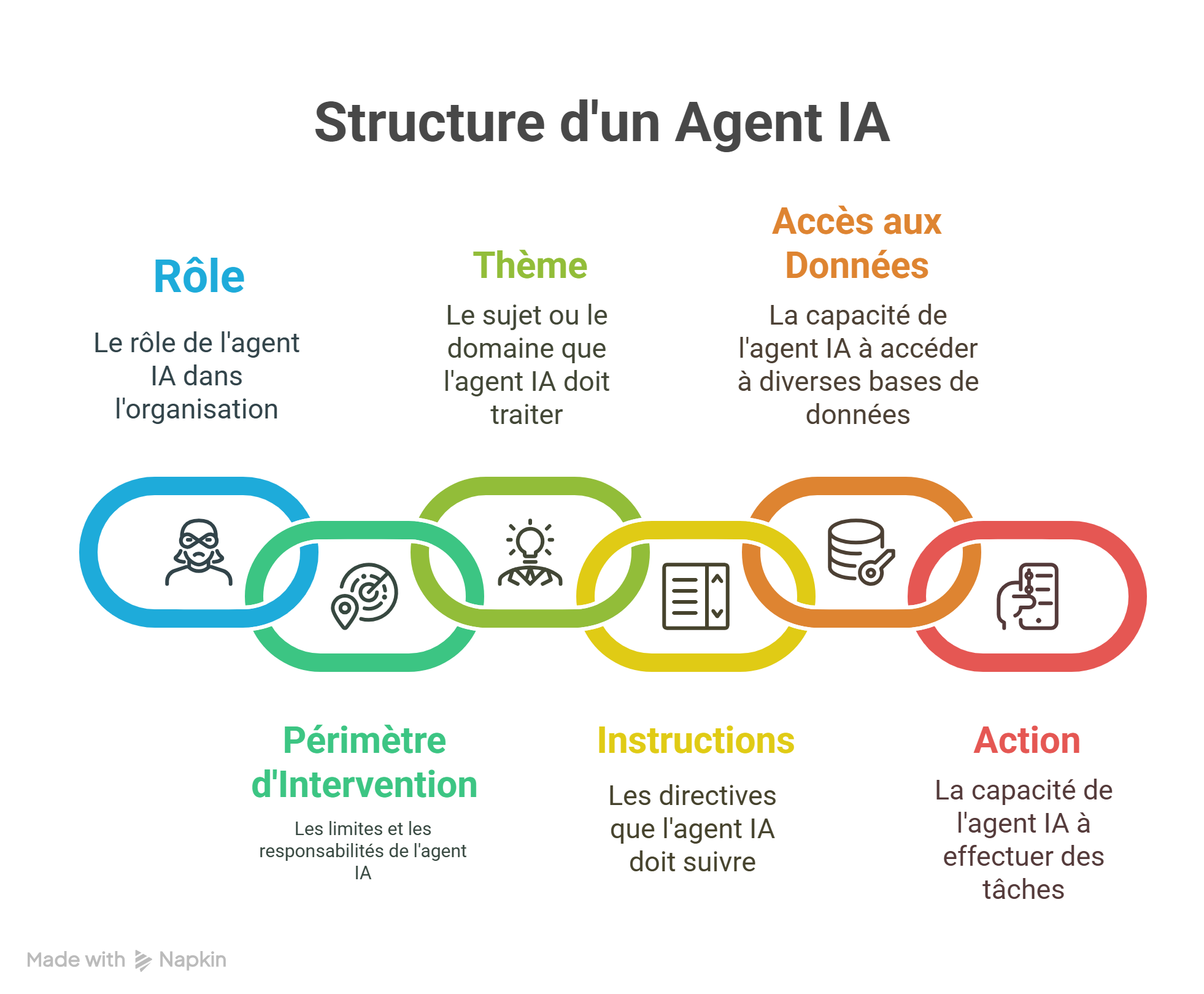

4 L’IA agentique aurait le potentiel de changer profondément le mode fonctionnement du CRM (sans le remplacer).

Le rôle des agents IA dans le CRM est de passer à l’action (contrairement à l’IA générative qui analyse et structure des données) en automatisant des processus complexes et en assistant les professionnels du CRM (ou ceux qui gèrent la relation client dans d’autres secteurs) dans leurs tâches quotidiennes.

Pour cela l’agent doit s’appuyer sur l’accès à diverses sources de données internes de qualité (! ), correctement structurées et nécessaire à sa tâche.

» Plus son écosystème d’accès aux données est large, plus il peut être autonome » précise Equancy.

- Exemple de fonctionnement de plusieurs agents en gestion de campagne

Dans le cadre d’une création de campagnes, un agent ‘créatif ‘ peut:

- aller chercher un brief ou recevoir un brief en mode vocal,

- accéder aux modèles de campagne existants,

- proposer une ou plusieurs créations (qui sont proposées sur un canal Slack par exemple),

- puis décliner le modèle sur différents canaux (SMS, email, push …),

- passer la main à un agent gestion de campagne.

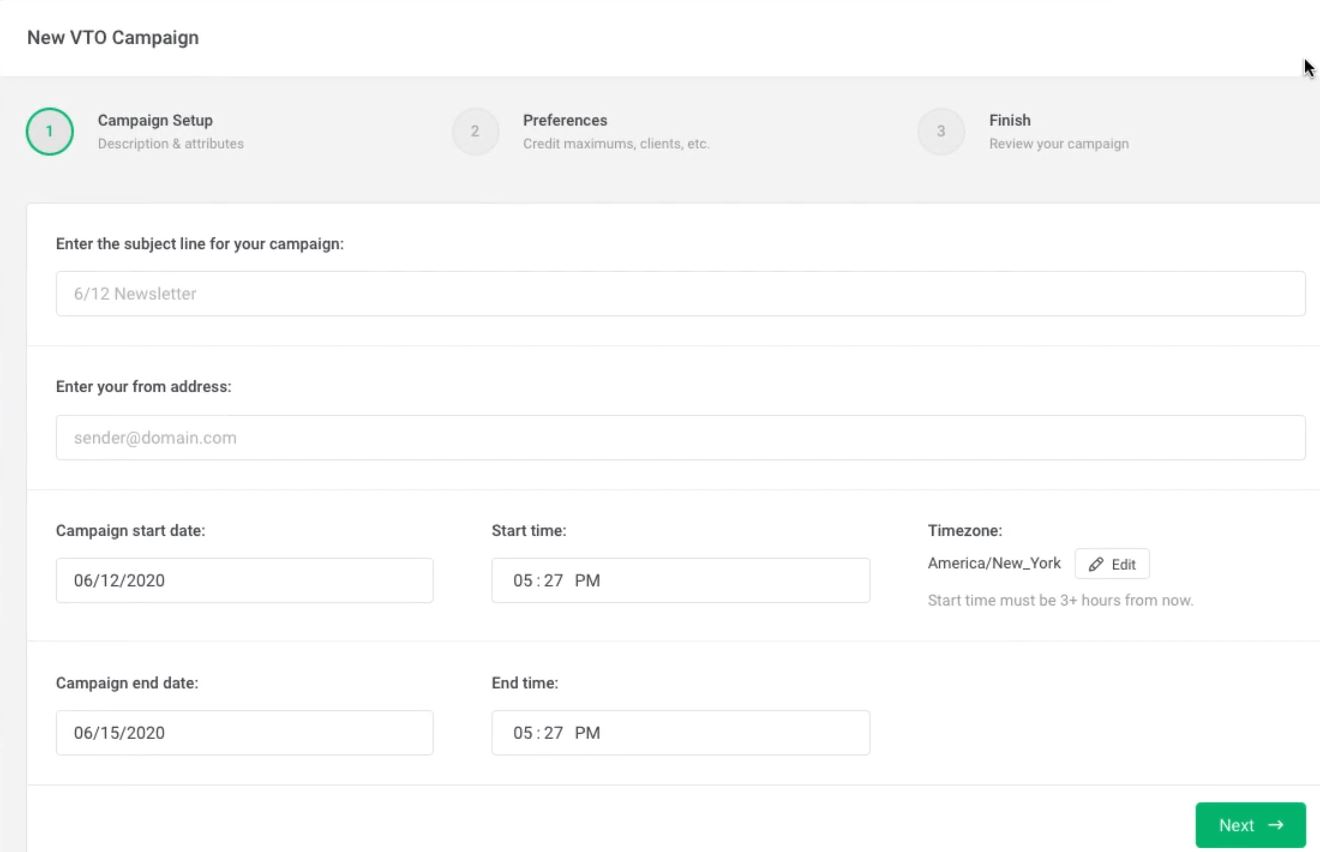

L’agent gestion de campagne pourra enchainer les actions suivantes :

- effectuer la requête de(s) cible(s),

- déclencher des BAT,

- cerner le meilleur moment d’envoi,

- déclencher l’envoi,

- suivre les retours et performances

- lancer l’agent ‘Resultat de campagne’, etc

L’objectif est bien d’automatiser et d’industrialiser la gestion de campagne qui est une tâche répétitive dont la valeur ajoutée est parfois faible (mais pas toujours).

Bien sûr dans ces automatisations, il faut des validations et contrôles fréquents, mais le gain de temps peut être considérable.

5 En synthèse : pour les agents une mise en œuvre technique sensible et exigeante

Techniquement, la mise en œuvre de tels agents, bien que paraissant simple en surface, peut impliquer une structuration complexe au niveau SI de l’entreprise et de l’intégration technologique des différents composants (base de données, accessibilité .. ) nécessaires au fonctionnement de l’agent.

Car il a besoin d’accéder à des données structurées de qualité (base de données client unique, référentiel produit, base documentaire de créations, etc) pour fonctionner sur l’ensemble de la chaine de production/analyse d’une campagne et aussi d’accéder aux outils CRM existant.

Ce dernier point semble limiter le développement d’agents à des structures techniquement matures sur toutes les phases de gestion de campagne et sur le SI marketing et produit de l’entreprise.

Enfin l’agent doit être entrainé sur les spécificités de l’entreprise (secteur d’activité, type de réponse attendue … ). Cela permet à l’agent d’intégrer le contexte de celle-ci, mais cela ne nécessite pas de réentraîner le modèle initial du LLM (avec ses milliards de paramètres). Derrière tout cela des choix technologiques importants dans un environnement pas toujours stable.

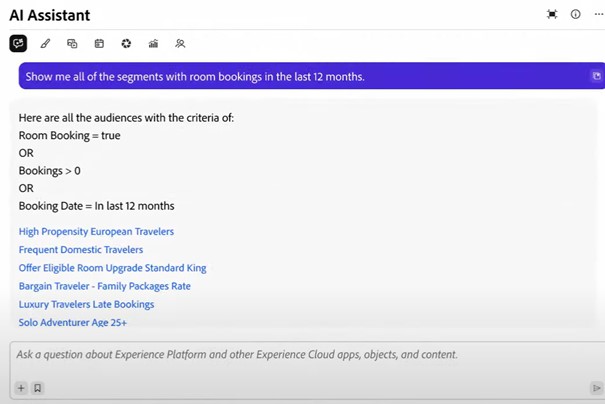

Adobe a présenté de ce type dispositif en mai 2024 lors de son

Adobe a présenté de ce type dispositif en mai 2024 lors de son

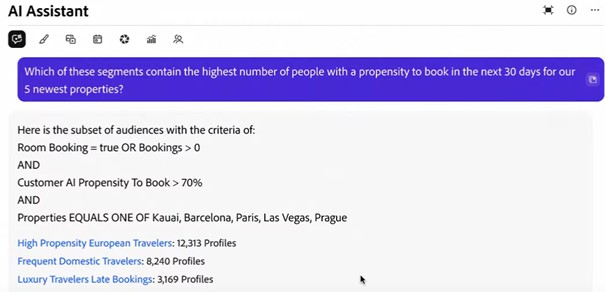

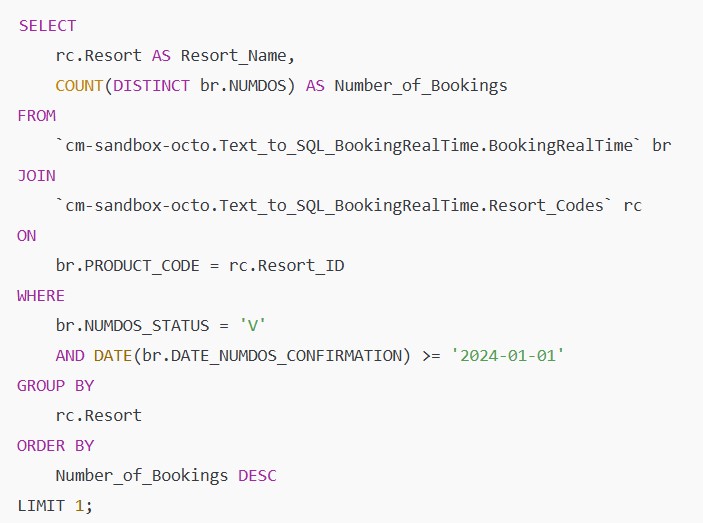

Fin 2024, dans un témoignage fort

Fin 2024, dans un témoignage fort  On est dans un cas plus complexe et sophistiqué que celui présenté par Adobe avec des jointures et des appels aux comptages et données précédentes.

On est dans un cas plus complexe et sophistiqué que celui présenté par Adobe avec des jointures et des appels aux comptages et données précédentes.